网络演进和数据业务的快速发展带动数据产业的快速发展,使数据中心的规模越来越大,消耗的电能也越来越来多,用电问题已成为制约数据业务发展的瓶颈。以一个10MW规模的数据中心为例,10年的生命周期内,用电成本约占数据中心整体运行成本的60%以上。PUE作为综合考察数据中心的用能效率指标,成为事实上衡量数据中心能效的KPI。因此各大IT厂商在如何降低PUE上使出了浑身解数,各出奇招。先来看几个典型的低PUE数据中心。

微软在英国苏格兰奥克尼群岛海岸线附近的水域部署的潜水艇式水下数据中心。所有部件预集成,并且可以利用海水进行自然冷却。

位于美国纽约州的洛克波特的雅虎鸡舍式数据中心。雅虎计算鸡舍完全放弃了机械式冷水机组,几乎完全依靠外部空气进行冷却。“计算舍”的PUE值大约为1.08。

Google位于比利时Saint-Ghislain的数据中心。该数据中心的蒸发冷却系统从附近的工业运河抽取用水, 实现了100%水侧自然冷却,全年平均PUE1.11。

这些数据中心都有一个共同点:高效利用自然冷源。而与此同时,他们也牺牲了灵活性。这些建设模式与环境强耦合,难以批量复制。不是所有的数据中心都能建在海里和山里,那我怎么降低PUE?

传统自动和人工调节面临困境

传统的冷冻水制冷系统由冷水机组、泵、冷却塔、末端等部分组成。由于制冷能耗与设备散热、设备配置、机房环境,外部气象条件相互关联,在运维达到一定的成熟度后,单纯凭借硬件节能或者基于人工经验的简单调优,都已经无法满足能耗进一步降低的要求。

冷冻水制冷系统的调节需要解决三个问题:

① 确保制冷系统的各部件运行在高效区间内(单部件最优)?

② 找出制冷系统内各个部件的最佳组合(全局最优)。例如同样输出1000KW冷量,冷却塔、冷却泵、冷机,冷冻泵各自的频率应当是多少?哪种组合更节能?

③ IT负载与制冷系统进行关联,实现热量需求与冷量供给的均衡。

基于传统专家经验的调优,多数只能解决第一步的问题,难以达成制冷系统全局最优。而且人工调节周期长,速度慢,无法满足节能降耗的相关诉求。

针对复杂的冷冻水制冷系统,需要找到一种新的控制算法,来达成整体最优。大数据,人工智能成为能效优化的一个探索方向。

华为iCooling创新解决方案

基于AI的iCooling数据中心能效优化解决方案,可在给定的气候条件、业务SLA等条件下,通过深度神经网络,自动推理出最优PUE下的系统参数,实现数据中心能效最优。其详细的实现方案如下:

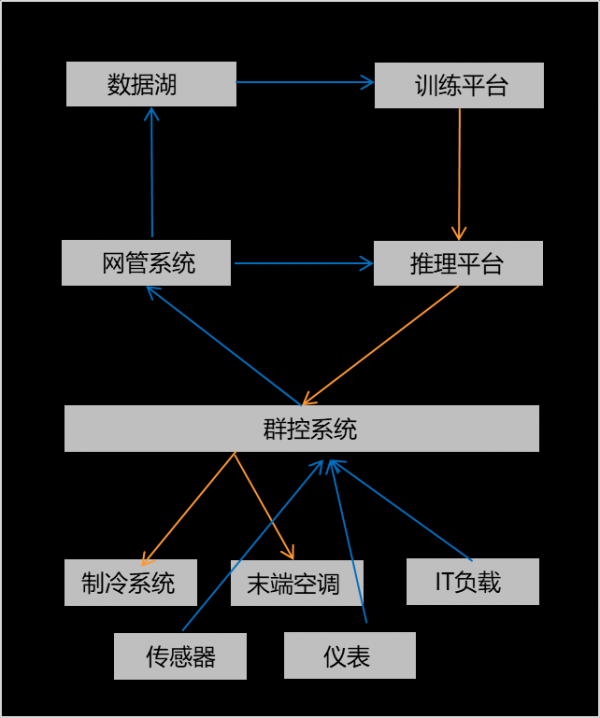

数据采集:采集冷冻站、末端空调及IT负载等系统的相关运行参数。以廊坊云数据中心二期为例,共700+采集点,共采集了9个月的运行参数; 数据治理:对原始数据进行降维、降噪、清洗等处理。华为强大的自动化治理工具,一亿条原始数据可以一个小时内完成治理,为后续的模型训练提供高质量数据; 模型训练:利用高质量的数据和DNN(深度神经网络),训练出PUE模型。经过训练的PUE模型,其预测准确率可达99.5%,误差<0.005。 推理决策:将训练好的预测模型发布到推理平台上。iCooling不仅能在1分钟内,利用预测模型从17万种组合中找出在当前室外环境、IT负载下的最优参数组合,并能根据要求进行多层过滤,最后得出最合适的指令,下发执行并反馈效果。

AI开启数据中心“智冷”新时代

华为廊坊云数据中心,在没有增加硬件成本的情况下,使用iCooling@AI技术,结合华为自研的能效最优的温控产品,打通IT负载到制冷系统再到整个外界环境之间的数据联动,把已建好的数据中心PUE降低了0.1,每年可节约数百万的电费。

随着相关算法理论的不断完善,计算能力的不断提高,人工智能获得了迅速的发展,人脸识别,智能搜索,人机对弈,自动驾驶等多种应用正在走向千家万户。在数据中心基础设施领域,AI也大有可为。AI+配电系统,智能分析故障根因,从被动告警到主动预防;AI+制冷系统,iCooling可以显著降低能耗,达成绿色节能目标;AI+运维系统,真正实现无人运维。

本文来源:中国IDC

Copyright © 2008-2025 Vansion Cloud All Rights Reserved 万盛云 版权所有

《增值电信业务经营许可证》IDC/ISP/ICP :粤B1-20213660号 粤ICP备14032135号 粤公网安备44051302000062号

TOP